De Facebook, de Twitter, de YouTube, de Google, de Whastapp… La censura en las plataformas a través de las que nos comunicamos. Una censura externalizada, privada, empresarial, sin mecanismos de defensa. Una censura global ejercida por las plataformas tecnológica y por las turbas estúpidas y paranoicas, por los enjambres digitales de hipócritas trolls.

¿Qué es censura?

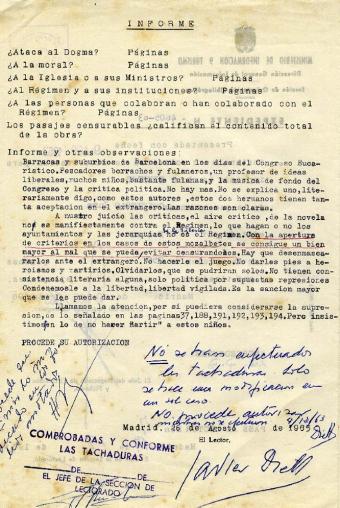

Un informe de un censor franquista: ¿atenta al dogma, a la Iglesia, al Régimen?

En sentido estricto, censura es el control previo de los mensajes que se van a difundir.

Censura es el proceso de control de la comunicación pública por el poder político y/o religioso. Supone un examen previo, la necesidad de obtener un permiso o placet de un poder público para difundir un mensaje público.

Es el control propio de las galaxias Gutemberg y Marconi.

Editar en el absolutismo era un privilegio real que se concedía a los impresores, sin perjuicio de la necesidad de obtener la aprobación previa del censor, político y/o religioso (a menudo la misma figura).

En el régimen liberal, la libre comunicación de pensamientos ideas se convierte en uno de los derechos más preciados, y cualquiera puede hablar, escribir o imprimir libremente «siempre y cuando responda del abuso de esta libertad en los casos determinados por la Ley» (art. 11 Declaración de Derechos del Hombre y el Ciudadano, 1789).

Se pasa, así, de un régimen de censura previa a un régimen de responsabilidad. El problemas son «los casos determinados por la ley». Dependiendo del momento histórico y de que gobiernos fueran más o menos liberales, los límites establecidos por la ley podían ser más o menos amplios.

En la Europa continental, durante todo el siglo XIX y la primera parte del XX fueron las leyes fueron bastante limitantes y los tribunales exigentes. Los límites se referían, en general, a la protección del Estado, sus dignatarios y sus símbolos, la protección de la propiedad, la religión dominante y la moral. Por supuesto, solo se exigía responsabilidad en la comunicación pública (prensa, primero, radio y televisión después), primero por su transcendencia social, pero también por la imposibilidad de controlar la comunicación privada.

Puede hablarse de censura en un sentido amplio cuando sin existir propiamente un control previo, el régimen de responsabilidad es tan estricto (límites amplísimos y mal definidos, sanciones administrativas, penas muy rigurosas, secuestro preventivo.

El caso del franquismo es bien ilustrativo. De la censura previa de la Ley de Serrano Súñer de 1938 a la cuasi censura de la Ley Fraga de 1966 (texto): límites amplísimos (art. 2), fuertes sanciones administrativas, responsabilidad penal, depósito previo y secuestro gubernativo. No pocas veces, decretado el secuestro por las autoridades administrativas (que conocían el contenido por el obligatorio depósito previo) la policía retiraba los ejemplares de los periódicos de los quioscos apenas estos abrían. La Constitución de 1978 prohibe cualquier tipo de censura previa y elimina el secuestro gubernativo (art. 20).

La censura hoy

En nuestro actual ecosistema comunicativo, la comunicación privada y la pública se funden. Por supuesto nos queda un ámbito privado de comunicación interpersonal, sin mediación tecnológica, pero más allá, hasta los mensajes intercambiados privadamente utilizando cualquier plataforma tecnológica pueden hacerse públicos por uno de los interlocutores y de hecho así ocurre muy frecuentemente.

El sistema libertad/responsabilidad se sigue aplicando a la comunicación pública estricta, a los mensajes profesionales en los medios de comunicación. Hasta aquí ningún problema (sin entrar ahora en la cuestión de si los tipos penales son proporcionados y actualizados o las normas de protección civil al honor y la propia imagen funcionan adecuadamente, que intentaré abordar en otra entrada).

El problema aparece cuando este esquema se aplica a mensajes privados o de grupo que se hacen públicos en las plataformas tecnológicas.

¿Tiene la misma responsabilidad el autor de un tuit que el de una columna de opinión en un periódico o el de una sátira en la televisión? Dependerá del contexto y la difusión del mensaje, pero no debe olvidarse que muchos de los mensajes no profesionales van dirigidos a un grupo, a una comunidad, que comparte ideas y valores y que, por tanto, su potencial ofensivo puede ser menor; además, en este entorno suele procederse de un modo informal, incluso como forma de diversión. Lo que desencadena el conflicto es la salida de la burbuja, el encadenamiento que hace viral el mensaje y le convierte en una forma plena de comunicación pública.

En resumen, en la actualidad se aplican los siguientes sistemas de control de la comunicación:

- Control editorial. El que ejercen los titulares de los medios de comunicación a través de instancias profesionales. En rigor más que de control, debiéramos de hablar de poder editorial. En situación de oligopolio o de preponderancia de los medios más poderosos, los propietarios, de hecho, moderan y restringen la comunicación pública, a menudo en connivencia con los poderes políticos. Los medios, en la denuncia de la corriente crítica, son «la voz de su amo». Por supuesto que la crítica tiene base, pero debe matizarse teniendo en cuenta la diversidad de voces (pluralismo externo), la función de control del poder político y el pluralismo entre los profesionales (pluralismo interno). Los medios audiovisuales públicos requilibran el poder editorial privado. Los medios hoy ya no son el único determinante de la comunicación pública, pero siguen sirviendo como enlace entre las burbujas privadas en que se ha fragmentado.

- Libertad/responsabilidad, aplicable a los mensajes difundidos en los medios masivos. En una sociedad democrática, no puede existir forma alguna de control previo y la responsabilidad solo puede ser exigida por los tribunales, por la comisión de un delito o por la exigencia de reparación establecidas en las leyes civiles que protegen la intimidad, el honor y la propia imagen. Los límites están establecidos en las leyes aprobadas en los parlamentos, son públicas, y el procedimiento de exigencia de responsabilidad lleva consigo un sistema de garantías y recursos.

- Libertad/responsabilidad, aplicación conflictiva en el ámbito de la comunicación público-privada de las plataformas tecnológicas. No está claro que actos tienen la entidad suficiente para generar responsabilidad y, por tanto, supone un cierto grado de inseguridad jurídica. Como en el caso 2, la exigencia de responsabilidad lleva consigo garantías y recursos.

- Control previo de las plataformas tecnológicas. Las empresas privadas ejercen un peculiar sistema de admisión, establecen normas poco transparentes sobre lo que se puede o no difundir y carecen de un verdadero sistema de recursos o garantías. El control no es previo, pero casi. Los algoritmos detectan instantáneamente los contenidos no aceptables y, bien los eliminan directamente, bien los someten a un proceso de evaluación humana. Sus gestores se resisten a ejercer un poder editorial, que llevaría consigo una responsabilidad que no quieren aceptar.

- Linchamiento digital. Ni estados, ni empresas, cada uno podemos ser ahora un cruel censor, denunciar cualquier cosa que no nos guste en las redes, pedir acciones contra quien sentimos que nos ha ofendido, insultarle impunemente, desarrollar campañas de boicot. En sociedades cada vez más polarizadas e intolerantes es la censura más peligrosa e inapelable (veáse, por citar solo el más reciente, el caso de Dani Mateo).

El caso de Facebook

Mensaje de Facebook de rechazo de una reclamación

Todas las plataformas de contenidos afronta parecidos problemas, pero Facebook es un mundo en si mismo. Con sus 2.200 millones de usuarios (¿cuántos activos?) se presenta como una nación digital global: «la Comunidad».

Para muchos de esos millones, Facebook es su fundamental espacio de comunicación: el lugar donde interaccionan con amigos y familiares reales y con los «amigos virtuales», el espacio en el que comparten y reciben informaciones que consideran, por su propio origen, fiables, aun cuando prácticamente todos sigan consumiendo información en unos medios tradicionales, en los que cada vez confían menos.

De modo que sí, el 4º método de control descrito más arriba, el control cuasi previo de los contenidos en las plataformas tecnológicas y especialmente en Facebook puede considerar la más relevante de las «censuras» de nuestros días.

Zuckerberg, como la mayoría de los «padres fundadores» de Silicon Valley es un libertario neoliberal, contrario a cualquier forma de regulación y convencido de que la tecnología es en si misma una arma de progreso capaz de resolver los problemas humanos con la fuerza bruta del cálculo y los algoritmos. Todos ellos consideran que sus plataformas simplemente han hecho tecnológicamente posible la utopía del libre mercado de ideas de Milton y Stuart Mill. Zuckerberg repite como un mantra que la misión de Facebook es construir «un mundo más abierto y conectado».

Así que ¿para que establecer controles sobre los mensajes si a mayor cantidad y diversidad más rico, en teoría, ese libre mercado de las ideas, convertido en la práctica en una propiedad privada que rinde más beneficios cuanto más se interactue con esos mensajes? (vía publicidad y venta de datos).

El primer problema lo plantean los derechos de autor. Los titulares del copyright no aceptan que se lleven a ese mercado productos protegidos. Quizá los primeros controles aparecen en YouTube (la segunda plataforma más influyente) para eliminar contenidos protegidos, como consecuencia de las presiones de las grandes empresas, especialmente los estudios de Hollywood.

Después las plataformas tendrán que afrontar los problemas de la privacidad, especialmente en relación con la normativa europea (notablemente reforzada en el nuevo reglamento). Y finalmente, las quejas de los propios usuarios, gobiernos o lobbys por la presencia de contenidos dañinos (¿para quién, en qué contexto?).

Facebook establece unas normas -estándares de la Comunidad los llama- sobre lo que puede o no ser publicado. Estas normas no son plenamente públicas hasta un fecha tan reciente como el pasado abril. Pero el resultado es que cuando se intenta publicar un determinado mensaje, sobre todo imágenes y vídeos, se recibe un mensaje de prohibición advirtiendo que el contenido viola esas normas.

Los documentales Les nettoyeurs y Dispatches revelan el proceso interno de control o moderación. Los algoritmos o las quejas de los usuarios se colocan en interminables listas de revisión los casos sospechosos. La «limpieza» corre a cargo de agentes contratados por terceras empresas, esto es, Facebook externaliza la censura. La carga de trabajo de estos agentes es enorme, su formación deficiente y sus conocimientos del contexto de esos mensajes nulo. De manera que lo más fácil es, en la duda, eliminar, so pena de entrar en discusiones casuísticas que retrasan el trabajo.

En los documentales vemos como los «limpiadores» eliminan fotos de Abu Grhaib porque las consideran propaganda del Estado Islámico. En otro caso, se reconoce que la foto de la niña abrasada por el napalm es un icono de la guerra de Vietnam, pero, puesto que se muestran los genitales, es un caso claro en el que las normas exigen su borrado. Y en cambio, resulta evidente como los supervisores deciden mantener los discursos de odio, porque alegan que son manifestación de la libertad de expresión y -ahí está la clave- porque generan mucha interacción.

Facebook ignoró las denuncias de que la plataforma se estaba utilizando como arma de guerra por los prorrusos en Ucrania, que en Birmania era el vehículo de la propaganda anti-roginha que llevó al genocidio. Pero entonces le estalló la interferencia rusa en las elecciones presidenciales norteamericanas y en concreto el caso Cambridge Analytica y Zuckerberg (con pocas habilidades comunicativas) no tuvo más remedio que dar explicaciones públicas, comenzando por un comité del Senado.

Una revisión de las normas comunitarias ahora públicas nos muestran unos principios generales, desarrollados con mayor o menor casuismo. Parece un ejercicio imposible de poner puertas al campo: cómo establecer que contenidos pueden considerar dañinos, para quién, en qué contexto, en dónde. Dan la impresión de mayor tolerancia con la violencia no terrorista, los suicidios o el discurso del odio que con los simples desnudos. Pero a la luz del proceso de revisión revelado por los documentales, qué se borra o no parece bastante aleatorio. Y un borrado sistemático puede significar que un icono tan relevante como el de la niña de Vietnam puede convertirse en inaccesible a para 2.200 millones de personas, o, por lo menos, para aquellos que se comunican esencialmente en el entorno de Facebook.

La pasada semana Zuckerberg respondió a las crítica con un post en el que presentaba un borrador para una nueva gobernanza.

Algunos elementos son, por lo menos para mi, preocupantes. Desarrollar métodos de Inteligencia Artificial para que los contenidos dañinos sean eliminados antes de que nadie pueda verlos (¡la censura previa del Gran Hermano!). Sostiene que sus herramientas de Inteligencia Artificial ya detectan y eliminan el 96% de los desnudos. Categorías prioritarias de control: terrorismo y daño autoinfringido.

Lo más relevante puede ser un cambio esencial en la dinámica de Facebook: desincentivar y netralizar la interacción con lo que Zuckerberg llama borderline content, los contenidos límite, esto es, los mensajes más próximos a lo que las normas prohiben, que son los que, hasta ahora más interacción consiguen.

Este hilo de Hugo Sáez lo explica brillantemente.

Estos dos gráficos que Mark Zuckerberg reveló ayer en su post en Facebook son, desde mi punto de vista, las dos piezas de información más importantes sobre las redes sociales que se han publicado en los últimos años.

Voy a intentar explicar porqué. pic.twitter.com/iabRbmZzwk

— Hugo Sáez (@Hugo_saez) 16 de noviembre de 2018

Entre estos contenidos límite, Zuckerberg cita la desinformación y el clickbait. ¿Seguirá siendo rentable la plataforma si elimina esos contenidos límite, que son los que logran mayor interacción? ¿Cómo neutralizarlos? Una de las líneas que avanza el fundador de Facebook es la corregulación.

Regulación del estatuto editorial

Facebook, como el resto de las plataformas de contenidos, siempre ha pretendido evitar las obligaciones propias de los medios de comunicación, en concreto, la responsabilidad jurídica por los contenidos que publican. De hecho, su marco legal ha sido el del comercio electrónico, tanto en Estados Unidos como en Europa (Directiva de Comercio Electrónico de 2002) o España (Ley de Servicios de la Sociedad de la Información, 2002).

Los acontecimientos del último lustro, especialmente la marea de la desinformación, y las críticas subsiguientes, les ha obligado a aceptar a regañadientes alguna forma de regulación.

En su reciente post, Zuckerber propone la corregulación, esto es, una regulación negociada con los estados y aplicada internamente. Concretamente, se muestra dispuesto a colaborar con la UE y con la ley de Macron contra la desinformación en campaña electoral, y que tantas críticas a recibido dentro y fuera de Francia. Otras medidas que propone es que todas las plataformas publiquen las métricas de contenidos dañinos y se compromete a crear antes del fin de 2019 un organismo independiente de recurso (¿único? ¿en cada país?). En fin, promesas vagas.

Que las plataformas tecnológicas no pueden ni deben ejercer el mismo control sobre la información que los editores de los medios de comunicación es evidente. Pero como de hecho cada vez ejercen un mayor control, este no puede ser opaco, confiando a herramientas de Inteligencia Artificial, con unas normas genéricas para toda la humanidad, en el marco de una relación de servicios, sin ningún tipo de garantías.

Se quiera o no, la solución hay que buscarla en el marco nacional o al menos multilateral. Por ejemplo, las plataformas podrían crear comités independientes nacionales, que adaptaran las normas y revisaran las quejas, siendo sus decisiones recurribles ante los tribunales. No puede esperarse que las plataformas se autorregulen, tienen que ser los legisladores nacionales los que creen un marco vinculante para la autorregulación, es decir, una corregulación efectiva.

Ciertamente, retrotraer el problema al marco nacional nos remite al sistema de control tradicional de los medios, lo que puede suponer en sociedades autoritarias anular las potencialidades democráticas de estas nuevas plataformas. Pero un paso adelante en Estados Unido o la Unión Europea marcarían la pauta, por mucho que Putin, Erdogan o Xi Jinping ejerzan una censura efectiva.

Responsabilidad de los medios públicos europeos es, sin pretender anular ni competir con las plataformas privadas, asumir esa tarea de construir sociedades más conectadas y abiertas de acuerdo con criterios de verdadero interés público.

Fuentes

Políticas de Facebook

- Normas comunitarias. Facebook, noviembre 2018.

- Mark Zuckerberg, A Blueprint for Content Governance and Enforcement, 15-11-18.

-

Facebook explica por primera vez qué censura y en qué se basa para ello. 20 Minutos, 24-8-18.

-

Facebook: Esto es lo que no te dejará publicar en tu perfil. La Vanguardia, 26-4-18-

La crisis de Facebook

- Delay, Deny and Deflect: How Facebook’s Leaders Fought Through Crisis. The New York Times, 14-11-18.

Documentales

Lamentablemente, los documentales de la Noche Temática solo están un tiempo limitado en rtve.es, por lo que solo los he podido encontrar en inglés. Lo mismo, lógicamente, que los dos documentales de Frontline, el espacio de investigación de PBS, dedicados a la crisis en torno al escándalo Cambridge Analytica y, en general, al dilema de adoptar o no una responsabilidad editorial.

- Les nettoyeurs de la web. ARTE, 2018 (Sólo he econtrado un enlace en Rutube. Google ha eliminado de YouTube algunos trailers)

-

Dispatches – Inside facebook. Secrets of the social network . Channel Four, 2018 (incrustado más abajo)

- The Facebook Dilemma. Frontline, PBS, ocxtubre 2018.